Big data is een marketingterm die het hele idee van data-ontgonnen omvat, van bronnen zoals zoekmachines, boodschappen van supermarkten gevolgd door puntenkaarten etc. In de moderne wereld heeft internet zoveel gegevensbronnen, dat de weegschaal vaak onbruikbaar maakt zonder dat verwerking en verwerking ongelofelijk veel tijd kost bij een enkele server. Voer Apache Hadoop in

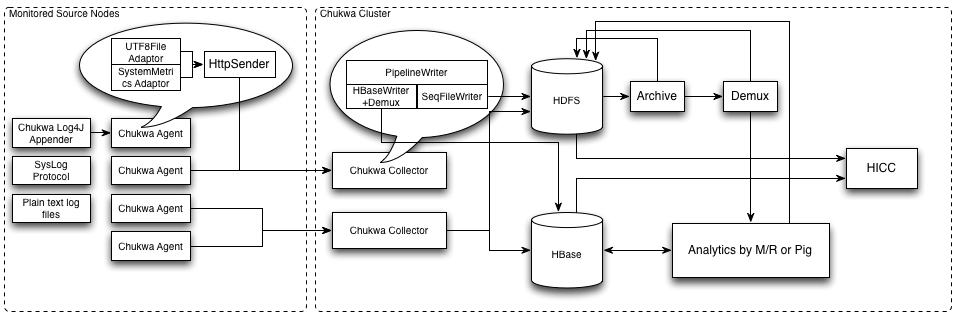

Minder tijd voor gegevensverwerkingDoor gebruik te maken van Hadoop-architectuur om verwerkingstaken over meerdere machines in een netwerk te distribueren, worden de verwerkingstijden astronomisch verlaagd en kunnen antwoorden binnen redelijke tijd worden bepaald. Apache Hadoop is opgesplitst in twee verschillende componenten: een opslagcomponent en een verwerkingscomponent. In de eenvoudigste bewoordingen maakt Hapood één virtuele server uit meerdere fysieke machines . In feite beheert Hadoop de communicatie tussen meerdere machines, zodat ze nauw genoeg samenwerken, zodat het lijkt alsof er maar één computer aan de berekeningen werkt. De gegevens worden verdeeld over meerdere machines om te worden opgeslagen en verwerkingstaken worden toegewezen en gecoördineerd door de Hadoop-architectuur

. Dit type systeem is een vereiste voor het converteren van onbewerkte gegevens naar bruikbare informatie op de schaal van Big Data-invoer. Overweeg de hoeveelheid gegevens die Google elke seconde ontvangt van gebruikers die zoekverzoeken invoeren. Als een totale hoeveelheid gegevens zou u niet weten waar u moet beginnen, maar Hadoop zal de dataset automatisch verkleinen tot kleinere, georganiseerde subsets met gegevens en deze beheersbare subset toewijzen aan specifieke bronnen. Alle resultaten worden vervolgens gerapporteerd en samengesteld tot bruikbare informatie .

Een eenvoudig in te stellen server

Hoewel het systeem ingewikkeld klinkt, zijn de meeste bewegende delen achter abstractie verdoezeld. Het opzetten van de Hadoop-server is vrij eenvoudig , installeer gewoon de serveronderdelen op hardware die voldoet aan de systeemvereisten. Het moeilijkste deel is het plannen van het netwerk van computers dat de Hadoop-server zal gebruiken om de opslag- en verwerkingsrollen te verdelen. Dit kan betrekking hebben op het opzetten van een LAN of het verbinden van meerdere netwerken op internet . U kunt ook gebruikmaken van bestaande cloudservices en betalen voor een Hadoop-cluster op populaire cloudplatformen zoals Microsoft Azure en Amazon EC2. Deze zijn nog eenvoudiger te configureren omdat u ze ad hoc kunt laten draaien en vervolgens de clusters kunt ontmantelen wanneer u ze niet meer nodig hebt. Deze typen clusters zijn ideaal om te testen, omdat u alleen betaalt voor de tijd dat het Hadoop-cluster actief is.

Verwerk uw gegevens om de informatie te krijgen die u nodig hebt

Big data is een extreem krachtige bron, maar gegevens zijn nutteloos, tenzij ze op de juiste manier kunnen worden gecategoriseerd en in informatie kunnen worden omgezet. Op dit moment bieden Hadoop clusters een uiterst kosteneffectieve methode voor het verwerken van deze gegevensverzamelingen in informatie.

Reacties niet gevonden